드론과 HD 카메라를 이용한 수심측량시 잘피에 의한 오차제거 알고리즘

Correction Algorithm of Errors by Seagrasses in Coastal Bathymetry Surveying Using Drone and HD Camera

Article information

Abstract

드론 항공사진을 L*a*b 색공간으로 변환하고 항공사진에서 잘피가 나타난 영역을 분할 및 보정하여 드론 항공사진을 이용한 수심측량의 정확도를 향상시켰다. 드론을 이용한 수심측량은 음향측심기와 같은 보편적으로 통용되던 방식에 비해 저비용으로 빠른 시간에 수심자료를 얻을 수 있다. 그러나 수심측량 대상 해역에 잘피가 서식할 경우 해저면의 반사 특성이 일정하지 않아 드론을 이용한 수심측량시 오차가 발생한다. 우리나라에 서식하는 잘피를 비롯한 해조류는 수온이 낮아지기 시작하는 11월부터 자라기 시작하여 1~4월에 최대 밀도를 형성한다. 따라서 해당 시기의 드론 항공사진을 그대로 사용할 경우 수심측량의 정확도가 낮아지며, 이는 드론을 이용한 수심측량방식을 상용화하는데 극복해야 할 단점이다. 본 연구에서는 경북 월포해수욕장에서 드론으로 촬영한 고해상도 카메라 이미지를 분석하여 오차 발생해역을 구분하고 보정하는 알고리즘을 개발하였다. 또한, 보정한 드론 항공 사진으로 천해 수심 추정을 수행하여 알고리즘을 검증하였다. 잘피로 인한 오차 보정 알고리즘 적용 전 수심 5 m 이내의 200 m × 300 m 해역에서 발생하는 오차 표준편차의 1.5배를 넘는 오차 이상값 비율은 전체 이미지의 8.6%를 차지하였다. 오차 보정 알고리즘을 적용한 결과 오차 이상값의 92%가 제거되었으며, 평균제곱근오차(RMSE)는 33% 감소하였다.

Trans Abstract

This paper presents an algorithm for identifying and eliminating errors by seagrasses in coastal bathymetry surveying using drone and HD camera. Survey errors due to seagrasses were identified, segmentated and eliminated using a L*a*b color space model. Bathymetry survey using a drone and HD camera has many advantages over conventional survey methods such as ship-board acoustic sounder or manual level survey which are time consuming and expensive. However, errors caused by sea bed reflectance due to seagrasses habitat hamper the development of new surveying tool. Seagrasses are the flowering plants which start to grow in November and flourish to maximum density until April in Korea. We developed a new algorithm for identifying seagrasses habitat locations and eliminating errors due to seagrasses to get the accurate depth survey data. We tested our algorithm at Wolpo beach. Bathymetry survey data which were obtained using a drone with HD camera and calibrated to eliminate errors due to seagrasses, were compared with depth survey data obtained using ship-board multi-beam acoustic sounder. The abnormal bathymetry data which are defined as the excess of 1.5 times of a standard deviation of random errors, are composed of 8.6% of the test site of area of 200 m by 300 m. By applying the developed algorithm, 92% of abnnormal bathymetry data were successfully eliminated and 33% of RMS errors were reduced.

1. 서 론

수심 자료는 해안에서 발생하는 다양한 수리학적 현상들을 파악하고 연안침식과 같은 환경문제들의 발생원인을 이해하기 위한 기초자료이다. 동시에 항만 구조물의 설계 및 시공 등에도 활용되는 공간정보이다. 기존 활용되고 있는 수심측량 기법으로는 사람이 직접 물에 들어가 레벨 측량 또는 RTK-GPS 장비를 사용하여 측량하는 방식, 선체에 음향측심기를 부착하여 수심을 측량하는 방법 등이 있다. 원격탐사로는 항공 LiDAR 또는 위성 자료를 이용한 수심측량 방법이 있다. 이러한 수심측량 방법들의 경우, 공통적으로 높은 비용이 소요된다. 또한 절차의 복잡성으로 인해 원하는 시간의 수심 자료를 빠르게 얻지 못하는 단점을 가지고 있다.

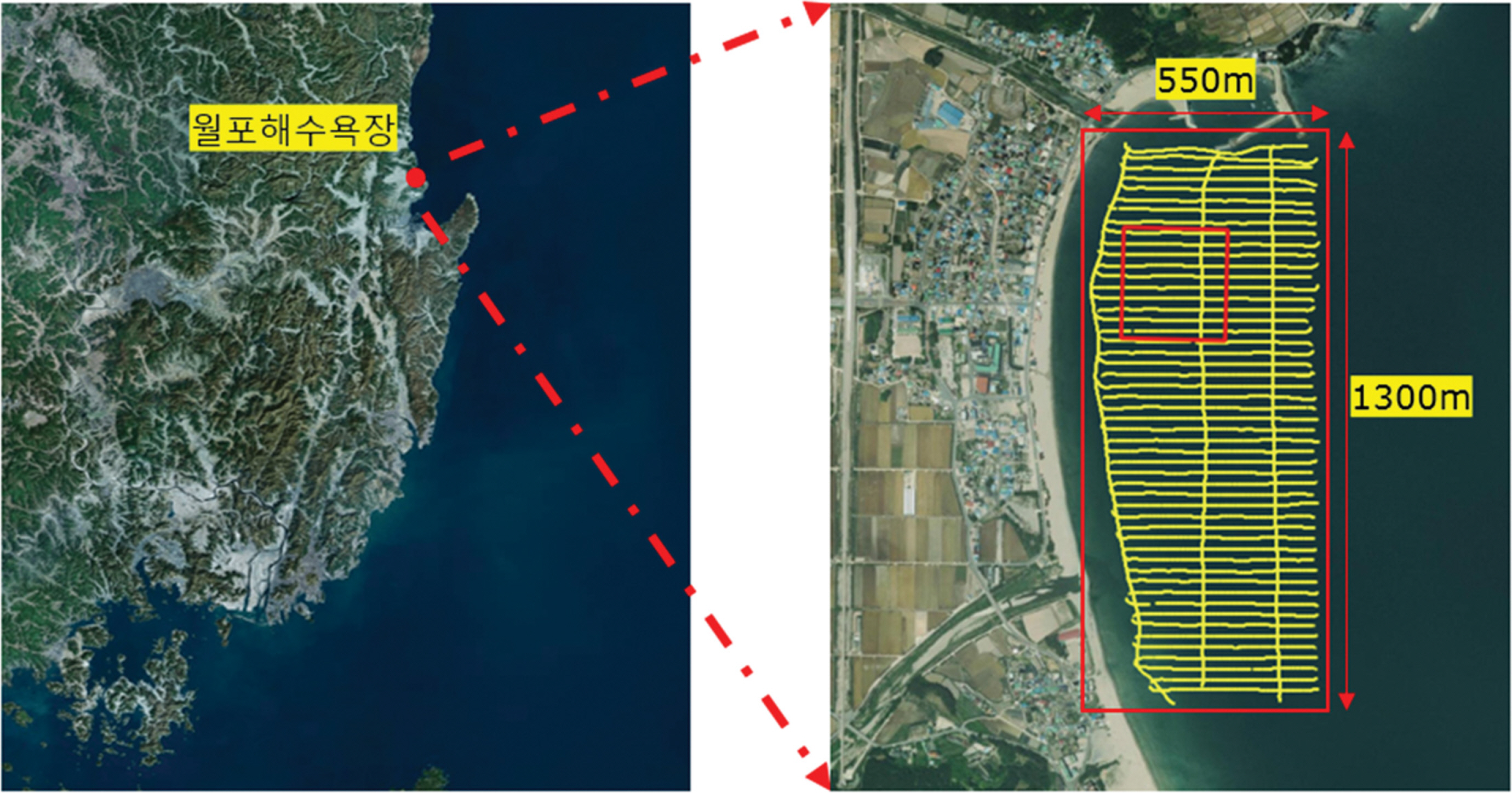

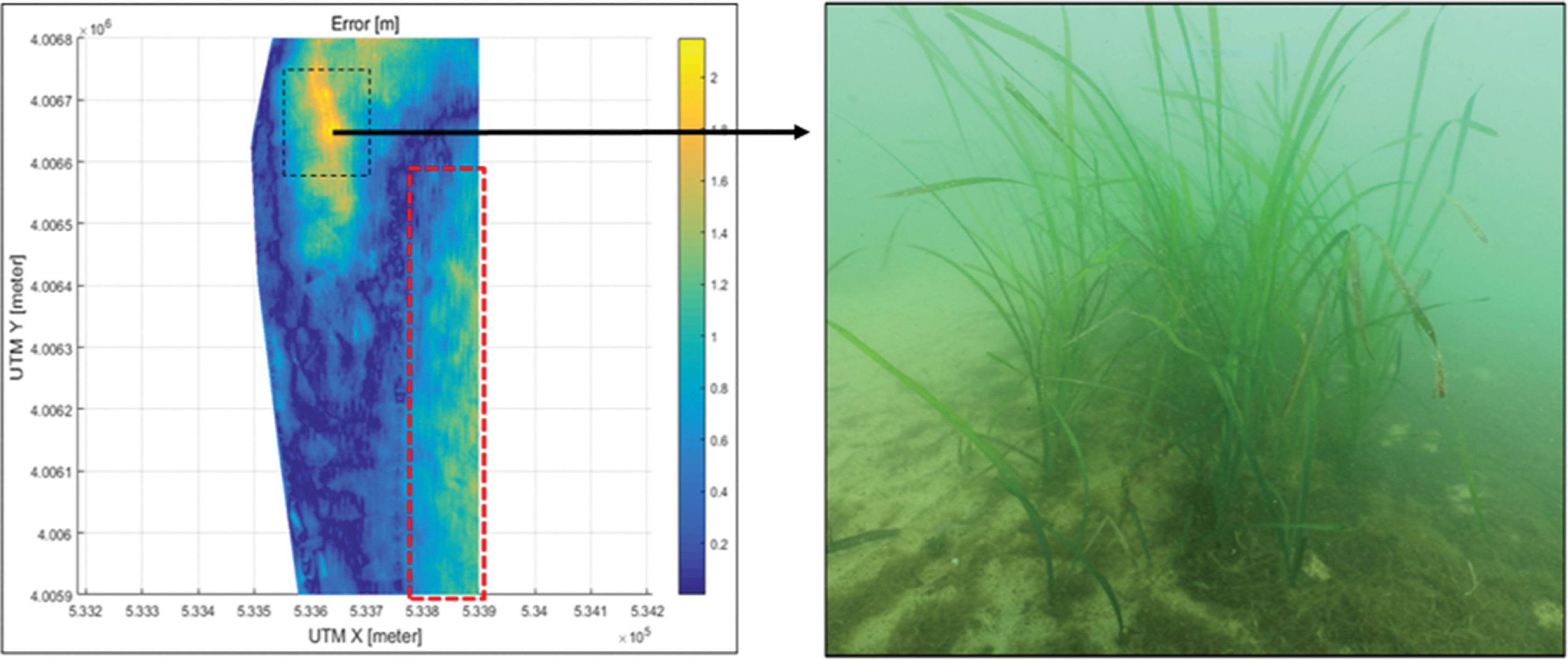

Ahn 등(Ahn et al., 2016)은 드론과 HD 카메라를 이용하여 적은 비용으로도 빠르게 원하는 시기의 연안 수심 자료를 취륵할 수 있는 방법을 제시한 바 있다. 드론과 HD 카메라를 이용한 수심측량은 빛이 물을 통과하면서 감쇠되는 비어람버트 법칙(Beer-Lambert Law)을 이론적 토대로 한다. Ahn 등(2016)은 경북 포항 월포해수욕장에서 촬영한 드론 항공사진의 적색 밴드 이미지를 활용하여 드론과 HD 카메라를 이용한 수심 측량의 가능성을 제시하였다. Yi et al.(2016)은 경북 울진 후정해수욕장을 대상으로 드론 항공사진의 적색, 녹색, 청색 밴드와 이를 합성한 회색 밴드 이미지의 픽셀 값을 기반으로 인공신경망을 이용한 수심측량 방식을 제시한 바 있다. Oh et al.(2017)은 경북 포항 월포해수욕장을 대상으로 드론 항공사진의 적색, 녹색, 청색 밴드와 이를 합성한 회색 밴드 이미지를 다변수 선형회귀분석법으로 수심측량 방식을 제시하였다. Fig. 1은 경북 포항의 월포해수욕장에서 음향 측심기와 드론으로 수심측량을 실시한 해역이다. Fig. 1의 오른쪽 그림의 550 m × 1300 m 직사각형내의 선박의 궤적을 따라 음향측심기로 수심 측량을 수행하였다.

Range of water depth estimation using a drone/HD camera at Wolpo beach. Right figure shows the trajectory of the survey ship with multi beam echo-sounder.

드론과 HD 카메라를 이용한 수심 측량은 대상 해역의 해저질이나 식생과 같은 물리적 특성으로 반사 특성이 변하는 것을 반영하지 못하는 한계가 있다. 이로 인해 Fig. 2의 왼쪽 그림에서 볼 수 있는 바와 같은 드론과 HD 카메라의 수심측량 오차가 나타나기도 한다. 그림에서 노란색 부분은 측정오차가 1 m 이상되는 해역이다. 이 오차의 원인은 해저면의 잘피 서식지에 의한 것임이 스쿠바 다이버의 수중촬영에 의해 밝혀졌다(Oh et al., 2017; Ahn et al., 2019). 잘피를 비롯한 해조류는 수온이 낮아지기 시작하는 11월부터 자라기 시작하여 1~4월에 최대 밀도를 형성한다. 이러한 상황은 특정 시기의 드론 항공 수심측량의 정확도를 낮춰 수심 자료로 활용하지 못하는 상황으로 이어진다.

(Left) Errors of water depth estimation obtained by subtracting depth of echo-sounder from estimated depth using images of drone/HD camera (Right) Underwater seagrasses photographed by scuba diver.

본 논문에서는 드론 촬영 이미지에서 수심측량의 정확도를 낮추는 잘피와 같은 해조류를 드론 항공사진에서 구분하고 보정함으로써 수심추정의 정확도를 높이고자 하였다. 일반적으로 해양환경에서 식생과 해저질을 파악하는데 다분광 영상을 사용한다(Taddia et al., 2020). 본 연구에서는 고비용 위성 자료의 다분광 영상과 드론용 다분광 센서 영상을 사용하지 않고 필요한 시점과 장소에서 수심측량이 가능한 드론에 의한 HD 카메라 영상 기반의 알고리즘을 구축하였다.

식생과 해저질을 파악하고 드론 항공 이미지로부터 오차 발생해역을구분및 보정하기 위해 CIE(Commission Internationale de l'Eclairage) L*a*b 색공간 모델을 기반으로 드론 항공사진을 분석하였다(Murali and Govindan, 2013). RGB 밴드로 구성된 드론 촬영 이미지를 CIE L*a*b 색공간 이미지로 변환, 드론 항공사진에서 빛의 휘도를 나타내는 L 밴드 픽셀 값을 이용한 임계처리를 통해 수심 측량의 정확도를 낮추는 오차발생해역을 분할 및 보정하였다. 보정 전후의 결과를 비교하기 위한 수심측량 방식으로는 다변수 선형회귀분석법을 활용하였다.

2. 이론적 배경

드론과 HD 카메라를 이용한 수심 측량은 비어-람버트 법칙(Beer-Lambert Law)을 바탕으로 수심추정식을 도출한다. 비어-람버트 법칙은 빛이 매질을 통과할 때, 산란하여 흡수됨에 따라서 세기가 약해지는 것을 말한다. 연안 수심에 따른 빛의 세기로 나타내면 Eq. (1)과 같이 표현할 수 있다. β는 흡수계수로, 이에 따라 기하급수적으로 수심이 깊어질수록 빛이 감쇠된다. 흡수계수는 파장에 따라 다르며, 바다가 푸르게 보이는 것도 가시광선 영역에서 붉은 영역의 흡수계수가 높기 때문이다. z는 수심이고, I는 카메라와 같은 센서에서 감지한 빛의 세기, Iw는 해수면에서 반사되는 빛의 세기. I0는 해저면에서 반사되어 올라오는 빛의 세기이다.

수심에 대한 식은 Eq. (1)을 변형하여 Eq. (2)와 같이 나타낼 수 있다.

카메라를 통해 감지된 빛은 파장에 따라서, 국제조명위원회(CIE)에서 지정한 색정합함수에 따라 비선형 변환되어 RGB 색공간 모델의 이미지로 표현된다. 이처럼 일반적인 카메라 영상에서는 빛의 세기가 직접적인 수치가 아닌 적색, 녹색, 청색의 밴드 픽셀 값으로 빛의 세기가 표현되기 때문에 Eq. (2)을 적용하는 것이 어렵다. 따라서 Lyzenga et al.(2006)는 물리적 특성이 일정하다는 전제하에 N개의 밴드 이미지를 이용한 수심추정식을 Eq. (3)과 같이 제안하였다.

여기서 h0와 hj은 ln(bandj) 값의다변수선형회귀분석법 (multiple linear regression)으로 결정되는 계수이다.

Oh et al.(2017)은 가시광선 영역의 밴드만을 사용하는 일반적인 HD 카메라의 특성과 데이터 형식에 맞춘 Eq. (4)를 제안하였다.

여기서 a0와 aj은 bandj 값의 다변수 선형회귀분석으로 결정되는 계수이다.

Yi et al.(2016)은 HD 카메라의 적색, 녹색, 청색, 회색의 밴드 픽셀 값을 기반으로 인경신경망을 통해서 수심을 추정하여 상관계수 0.97, 평균제곱근오차(RMSE) 0.63 m인 수심 추정식을 구축하였다. HD 카메라 이미지를 이용한 수심측량에서 추정해역 해저의 상태에 따라 정확도가 급격히 변하는 것을 관찰할 수 있다(Oh et al., 2017). 특히 해저에 해초 서식지가 존재할 경우 심각한 오차가 발생한다. 본 연구의 목표는 오차발생해역을 구분 및 보정하는 것이다. 이에 따른 보정 전후의 결과 비교를 위해 수심추정식을 작성하기 때문에, 추정과정에서 물리적 특성이 나타나지 않는 인공신경망 추정방식을 사용하지 않았다.

CIE L*a*b 색공간 이미지는 일반적인 HD 카메라 RGB 영상으로부터 비선형 변환을 통해 구축된다. CIE L*a*b 색 공간 모델의 경우, 사람의 시각과 가장 유사하게 표현된 색 공간 모델이다. 휘도를 나타내는 L 밴드와, 적색과 녹색을 나타내는 a 밴드, 황색과 청색을 나타내는 b 밴드로 구성되어 있다. CIE L*a*b 색공간 모델은 빛의 휘도를 나타내는 L 밴드로 음영을 조절하여 영상 분할의 정확도를 향상하는데 활용된다(Murali et al., 2013; Hu et al., 2020). 특히 농작물이나 식생을 분할하는 알고리즘에서 높은 성능을 보인다(Bookya et al., 2020). Ahn et al.(2019)은 드론과 HD 카메라를 이용한 수심측량에서 해저질과 잘피 서식지로 인해 달라지는 해저면의 반사 특성이 심각한 오차를 발생시켰다고 보고하였다. 휘도를 나타내는 L 밴드의 특성을 기반으로 반사특성을 파악하고 오차발생해역을 구분 및 보정하여 드론과 HD 카메라를 이용한 수심측량방식의 정확도를 높였다.

3. L*a*b 색공간 모델을 이용한 오차발생해역 구분

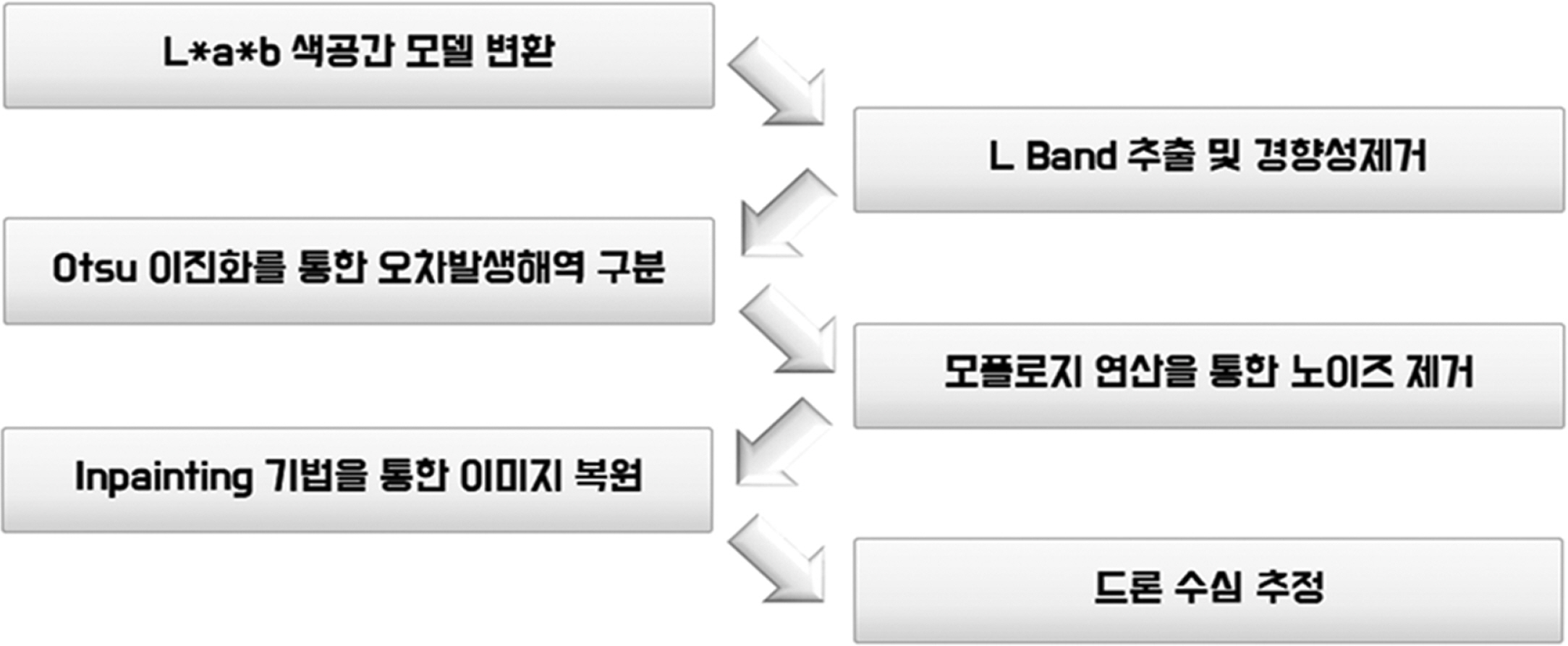

본 연구에서의 오차발생해역을 구분하는 알고리즘의 순서는 Fig. 3과 같다. 먼저 드론 항공사진을 L*a*b 색공간 모델 이미지로 변환한다. 변환된 L*a*b 이미지로부터 휘도를 나타내는 L 밴드 이미지를 추출하여 광원과 수심에 따른 경향성을 제거한 후 인페인팅(inpainting) 기법을 사용하여 이미지를 복원하고 수심을 추정한다. Fig. 4는 선행연구에서 잘피로 인해서 심각한 오차가 발생한 해역을 확대한 부분의 L 밴드 이미지와 단면의 L 밴드 픽셀 값을 나타낸다. 주변보다 어둡게 보이는 오차 발생해역의 경우, 빛을 흡수하는 잘피의 특성으로 인해서 인근 해역보다 L 밴드 픽셀 값이 낮고 실제 수심보다 깊게 추정되는 것을 확인할 수 있다. 오차 발생해역의 L 밴드 픽셀 값이 주변보다 낮은 특성을 기반으로 Otsu 임계처리 알고리즘(Otsu, 1979)을 통해서 드론 이미지로부터 오차 발생해역을 구분하였다. Otsu 임계처리 알고리즘은 비모수 (nonparametric)와 무감독분류(unsupervised) 방법으로 경계가 모호한 부분의 경계를 확정하는 알고리즘으로 잘피와 주변 모래를 구분하기 위하여 사용하였다.

(a) L band image, (b) Relationship between error occurrence area and L band value along the horizon line A. Red line represents depth estimation from the drone/HD camera.

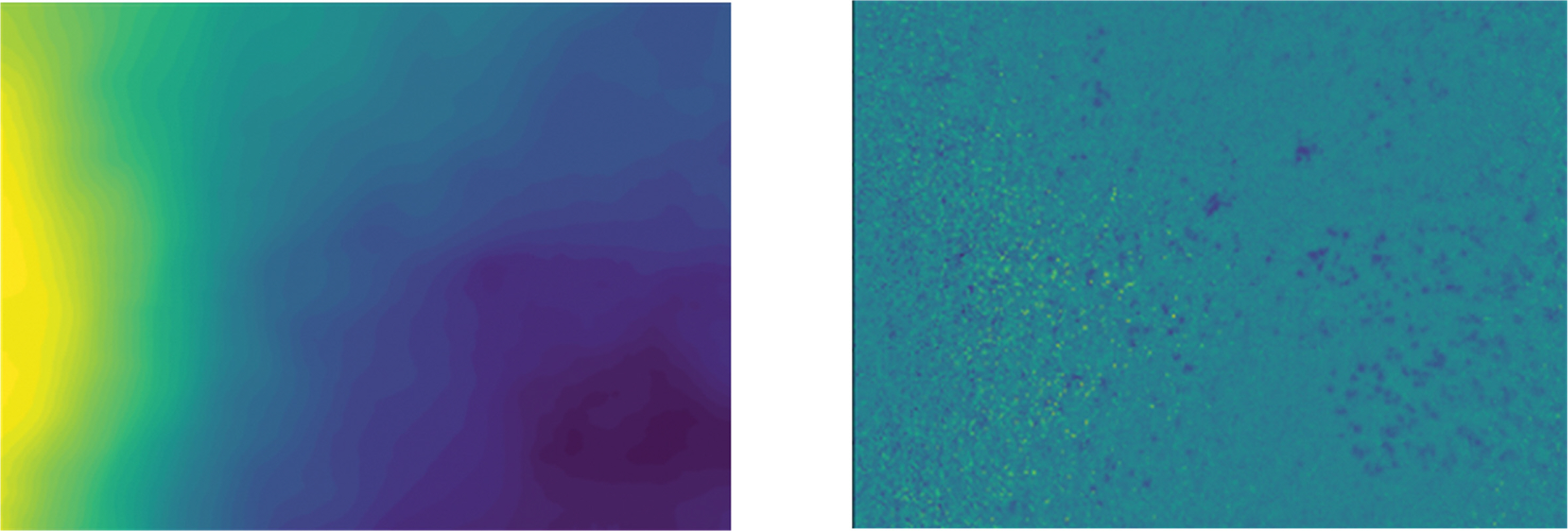

드론 항공사진에서 L 밴드 픽셀 값의 경우, 광원에게서 멀어지면서 감소하며, 수심이 깊어질수록 또한 감소하기 때문에 Fig. 5의 (b)와 같은 경향성을 보인다. Otsu 임계처리 알고리즘을 통해 오차 발생해역을 구분하기 위해서는 드론 항공사진에 나타난 L 밴드의 경향성을 제거해야 한다. L 밴드의 경향성을 제거하고자 x축과 y축에 따른 회귀분석 및 평균 필터 처리를 통해 Fig. 5의 (b)와 같이 경향성을 추출하였다. L 밴드 픽셀 값의 최대치에서 추출한 L 밴드 경향성 이미지의 픽셀 값을 빼서 반대되는 경향성 이미지를 만든다. 반대되는 경향성 이미지의 픽셀 값을 원본 이미지에 더하여 L 밴드의 경향성을 제거한다.

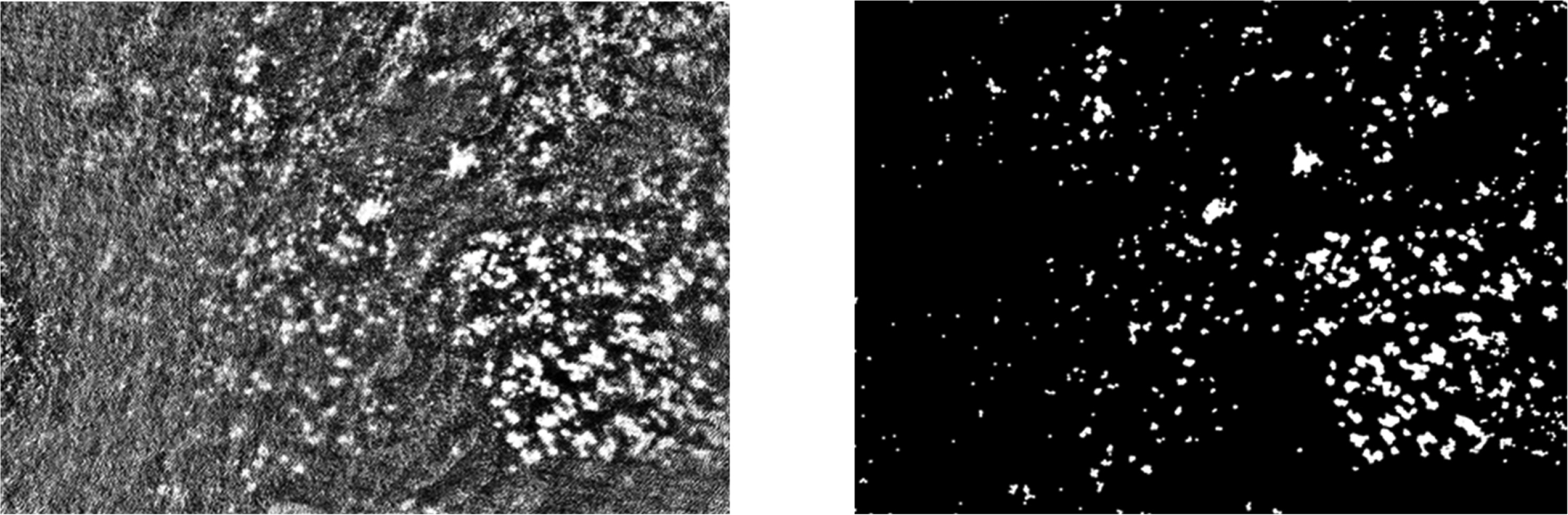

Fig. 6의 왼쪽 그림은 분석해역의 L 밴드 이미지이며, 오른쪽 그림은 광원의 위치로부터의 거리와 수심이 깊어짐으로 나타나는 L 밴드의 경향성을 제거한 이미지이다. L 밴드의 경향성이 제거된 이미지로부터 Otsu 임계처리 알고리즘을 사용하여 오차 발생해역을 구분한다. Otsu 임계처리 알고리즘은 입력 영상의 히스토그램으로부터 통계적으로 가장 적절한 임계 값을 자동으로 결정한다(Otsu, 1979). Fig. 7은 Otsu 임계처리 알고리즘에 의해 처리된 이미지이며, 왼쪽 그림에서 볼 수 있듯이 오차를 발생시켰던 잘피 서식지가 해수면에 발생한 파랑, 잔물결과 함께 분할된 것을 확인할 수 있다. Fig. 7의 오른쪽 그림은 Otsu 임계처리 결과에서 모폴로지(morphology) 연산을 통해 분할된 파랑과 잔물결을 제거하여 잘피 위치만을 표기하였다. 오차 발생해역 잘피의 이진분류 결과를 바탕으로, 이미지 복원 기법을 적용하여 Fig. 8의 오른쪽 그림과 같이 잘피에 의한 오차발생해역을 보정한 드론 이미지를 생성하였다.

(left) Otsu threshold image which represents seagrass locations at thee sea bottom along with waves and ripple on the sea surface (right) Segmentation of seagrass habitat shown as white speckles.

(left) Original HD image taken by drone (right) Correction result of HD image without seagrasses, waves and ripple.

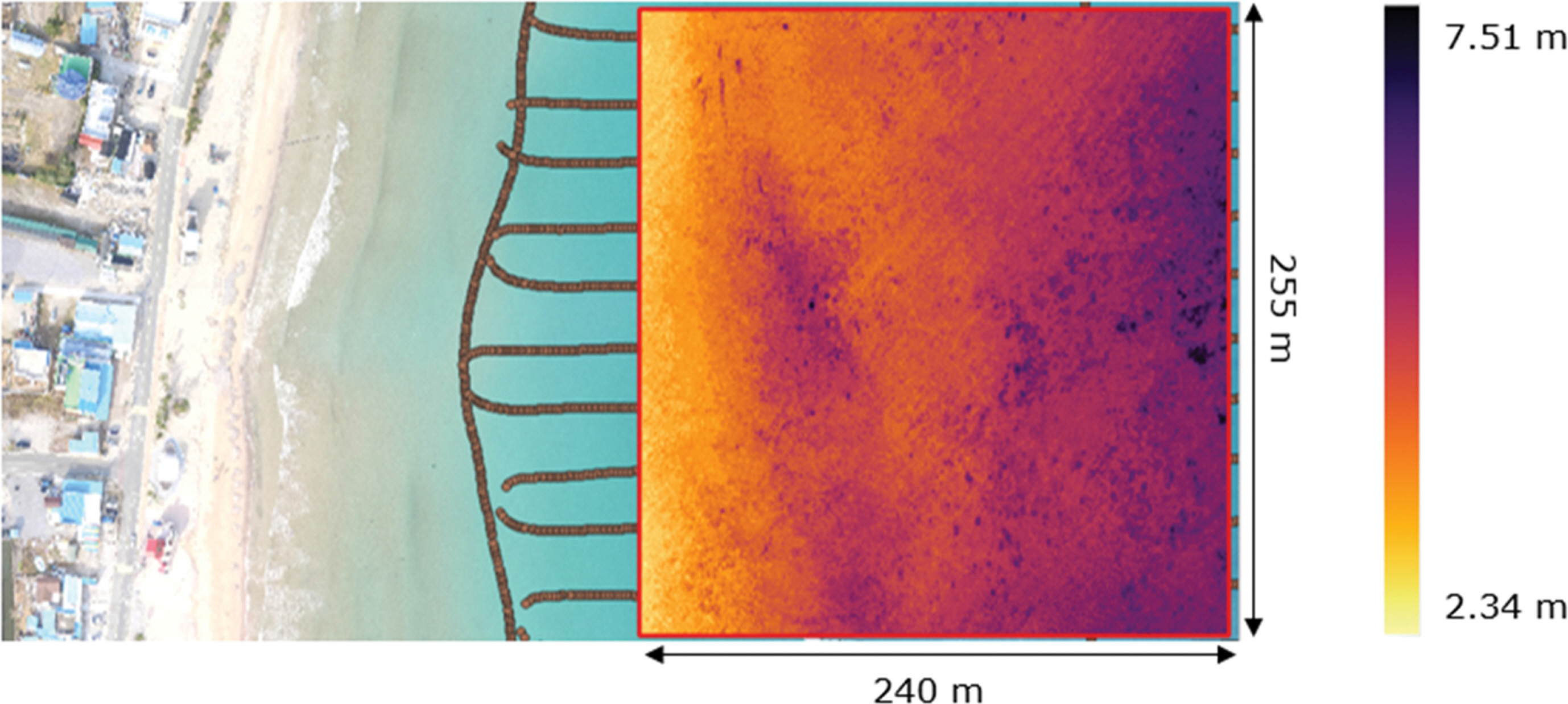

오차 발생해역 보정 알고리즘의 유효성을 검증을 위해서 경북 포항 월포해수욕장의 잘피 서식지를 중심으로 수심추정을 진행하였다. GIS 소프트웨어인 QGIS를 이용하여 음향측심 자료와 드론 항공사진을 지오레퍼런싱(Georeferencing)하였다. 음향측심 자료를 종속변수로 사용하여 다변수 선형회귀분석을 통해 수심추정식을 도출하였다. 회귀분석 결과의 정확도를 높이기 위해 다중공선성(multicolinearity)을 고려하여 독립적인 적색, 녹색, 청색 밴드의 이미지 값만을 독립변수로 사용하였다. 변수에 따른 수심추정식의 계수는 Table 1과 같다. 상관계수 0.964의 정확도와 제곱평균제곱근오차(Root Mean Square Errors) 0.384 m로 수심을 추정할 수 있었다. Fig. 9은 드론에 의해 추정된 수심이며 240 m × 255 m 해역에서 2.34 m에서 7.51 m 깊이임을 알 수 있다.

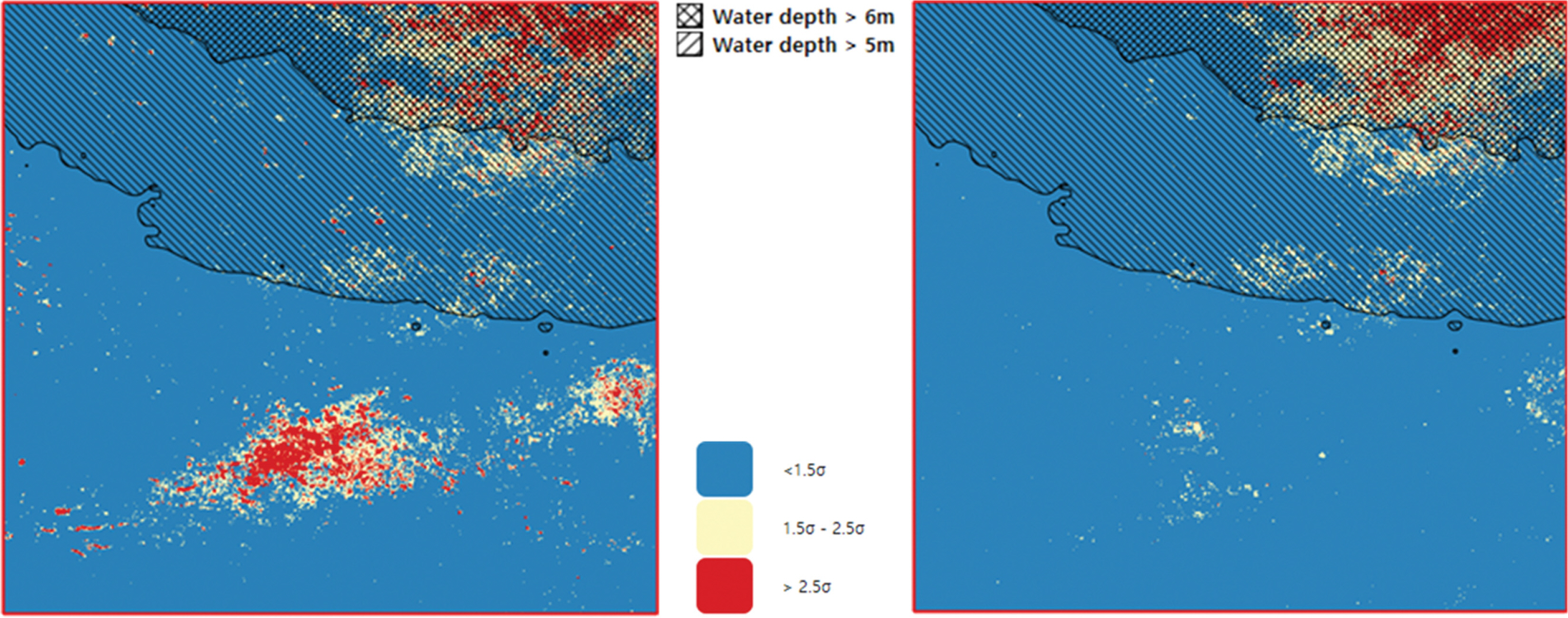

수심추정식을 바탕으로, 원본 드론 항공사진과 보정된 드론 항공사진을 대상으로 수심을 추정하고 결과를 비교하였다. Fig. 10은 추정된 수심 값과 음향측심 결과를 비교한 오차를 나타낸다. 음향측심기의 수심추정 시에도 해저에 잘피가 존재할 경우 오차가 발생하며 음향측심기의 잘피에 의한 오차에 대한 자료가 없기 때문에 여기서 표현된 오차는 절대오차가 아니라 음향측심기와 비교한 상대오차라고 판단된다. 표준편차의 1.5배를 넘는 오차 이상치를 비교하였다. Fig. 10의 검은 사선으로 표현된 영역은 수심이 5 m와 6 m 이상의 바다영역을 나타내며, 그림에서 볼 수 있듯이 수심이 5 m 이상일 경우 가시광선의 대부분이 흡수됨으로 인해 오차가 발생됨을 알 수 있다. 본 연구에서 HD 이미지를 이용한 수심추정 시 수심 5 m 이하인 경우 잘피에 의한 수심추정의 정확성을 확보하는 것이 목적이므로 수심 5 m 이하의 바다를 대상으로 분석하였다. 수심 5 m 이내의 해역에서 발생하는 오차 이상치 비율은 전체 이미지의 8.6%를 차지하였다. 보정 전 최대 오차는 3.01 m, 제곱평균제곱근오차(RMSE)는 0.386 m로 나타났다. 보정 후 최대 오차는 1.17 m, 평균제곱근오차(RMSE)는 0.259 m로 나타났다.

Comparison between errors of the previous algorithm (left) and errors of the correction algorithm (right).

전체 해역의 넓이 대비 오차 발생해역의 넓이를 고려할 때, 높은 수준의 정확도 향상을 확인하였다. 또한 표준편차 1.5배를 넘는 오차 이상치의 92%를 제거하는 것을 확인하며 알고리즘의 유효성을 검증할 수 있었다.

4. 결 론

경북 포항 월포해수욕장에서 드론에 장착된 HD 카메라를 이용하여 수심추정을 수행하였다. 드론 항공사진에서 L*a*b 색공간 기반의 영상분석을 통해 잘피가 나타난 영역을 분할 및 보정하였다. 해저면에 서식하는 잘피는 빛을 흡수하여 드론을 이용한 수심측량의 정확도를 낮춘다. L*a*b 색공간에서 명도를 나타내는 L 밴드를 활용하여 잘피를 분류하였다. 분류된 결과를 바탕으로 드론 항공사진을 보정하고 다중회귀분석을 통해서 수심을 추정하였다. 드론 항공사진에 의한 수심 측량시 수심 5 m 보다 깊어질 경우, 수심에 의해 RGB 밴드가 대부분 흡수됨으로 인해 오차가 발생한다. 본 수심추정에서는 수심 5 m 이내에 적용하였으며, 보정 전의 최대오차는 3.01 m, 제곱평균제곱근오차는 0.386 m, 보정 후의 최대오차는 1.17 m, 제곱평균제곱근오차는 0.259 m로 나타났다. 오차표준편차의 1.5배를 넘는 오차 이상 값의 비율은 전체 이미지에서 8.6%로 나타났다. 보정을 통해서 92% 이상 오차를 제거하였고, 제곱평균제곱근오차는 33% 감소하였다. 전체 항공사진 대비 잘피 면적의 비율을 고려할 때, 정확도가 크게 향상되었음을 확인하였다.

한편, 드론 항공사진 촬영 시기마다 태양의 고도가 달라지면서 절대적인 광량의 차이가 발생한다. 광량 센서를 부착하여 시기에 따른 절대적인 광량을 보정하면 드론과 HD 카메라를 이용한 수심측량의 유용성과 정확성을 확대 활용할 수 있을 것으로 기대된다. 더 나아가, 해양환경을 위한 연안생태계 유지에 잘피 서식지가 중요한 역할을 하는 만큼, 본 연구의 결과를 잘피 서식지 모니터링에도 활용할 수 있을 것이다.

Acknowledgements

본 연구는 해양수산부가 후원하는 “경북씨그랜트 프로그램”의 지원으로 수행된 연구임.